KI in der Verwaltung

Wie lassen sich mögliche Folgen von KI-Anwendungen bewerten? – Ein Interview mit Tobias Krafft

Veröffentlicht am 18. Nov 2021

KI-Anwendungen kommen in mehr und mehr Bereichen zum Einsatz. Doch was passiert, wenn sie Fehler machen? Hier macht es einen Unterschied, ob eine KI-Anwendung beim Online-Shopping weitere Artikel vorschlägt oder die Personalabteilung bei Bewerbungsverfahren unterstützt. Das Netzwerk KI in der Arbeits- und Sozialverwaltung hat sich im September und Oktober gemeinsam mit Tobias Krafft von der TU Kaiserslautern damit beschäftigt, wie man zwischen kritischen und weniger kritischen KI-Anwendungen unterscheiden kann und was das für den KI-Einsatz in den Behörden bedeutet.

Herr Krafft, Sie haben eine sogenannte "Kritikalitätsmatrix" mitentwickelt, mit der sich mögliche Auswirkungen von KI-Systemen bewerten lassen. Worum geht es dabei genau?

Die Kritikalitätsmatrix kann als initiale Risikoabschätzung sowohl bei der Entwicklung als auch beim Einsatz einer KI verwendet werden. In beiden Fällen wird ein KI-System in seinem spezifischen Anwendungskontext im Hinblick auf ein mögliches Schädigungspotenzial bewertet, das beispielsweise durch falsche Entscheidungen des KI-Systems entstehen kann.

Mithilfe der Kritikalitätsmatrix lässt sich die entscheidende Frage nach der Höhe des Gesamtschadenspotenzials genauer ermitteln, sodass bereits im Vorfeld geeignete Maßnahmen zur Schadensbegrenzung getroffen werden können. Die Relevanz wird schnell klar, wenn man die Einsatzbereiche verschiedener KI-Anwendungen vergleicht. Mögliche Schäden durch ein KI-System, das basierend auf Kamerabildern beispielsweise Schrauben auf einem Fließband bewertet, wird ein niedriges Schädigungspotenzial aufweisen, wohingegen ein KI-System, das zur Vorhersage von Chancen auf dem Arbeitsmarkt eingesetzt werden soll, ein ungleich höheres Schadenspotenzial hat. Abhängig vom ermittelten Gesamtschadenspotenzial lassen sich dann angemessene technische Forderungen an Transparenz und Nachvollziehbarkeit des KI-Systems formulieren oder risikomindernde Maßnahmen entwickeln.

Wie funktioniert Ihr Modell konkret?

Zur Bestimmung des Gesamtschadenspotenzials spielen zwei Dimensionen eine Rolle. Die erste Dimension ergibt sich aus dem tatsächlichen Schaden, der im Fall einer Fehlentscheidung entstehen würde. Neben den individuellen Folgen bzw. Schäden müssen bei der Bewertung auch etwaige gesamtgesellschaftliche Schäden berücksichtigt werden, die mit dem Einsatz und der Verwendung des Systems verbunden sein können. Ein aktuelles Beispiel dafür sind die vielfach diskutierten Upload-Filter, die im Falle eines Fehlurteils des zugrundeliegenden KI-Systems auf individueller Ebene lediglich eine gewisse Unsicherheit bei den Nutzern erzeugen, aber gesamtgesellschaftlich betrachtet erhebliche Schäden verursachen können.

Die zweite Dimension beschäftigt sich mit der Frage, ob und wenn ja, inwieweit eine Person von der Entscheidung einer KI betroffen ist. Hierauf haben zum Beispiel Widerspruchs- und Wechselmöglichkeiten einen Einfluss. Während in vielen Bereichen eine Anbietervielfalt das Gesamtschadenspotenzial reduziert, führt ein hoheitlicher Einsatz von KI meist zu einem Anstieg. Grund hierfür ist, dass Bürgerinnen und Bürger unter Umständen keine andere Wahl haben, als sich durch das KI-System bewerten zu lassen. Hier können wiederum Einspruchs- und Interventionsmöglichkeiten das Schadenspotential reduzieren. Es ist also der konkrete Anwendungskontext eines KI-Systems, der maßgeblich dessen Gesamtschadenspotential beeinflusst.

Übersicht

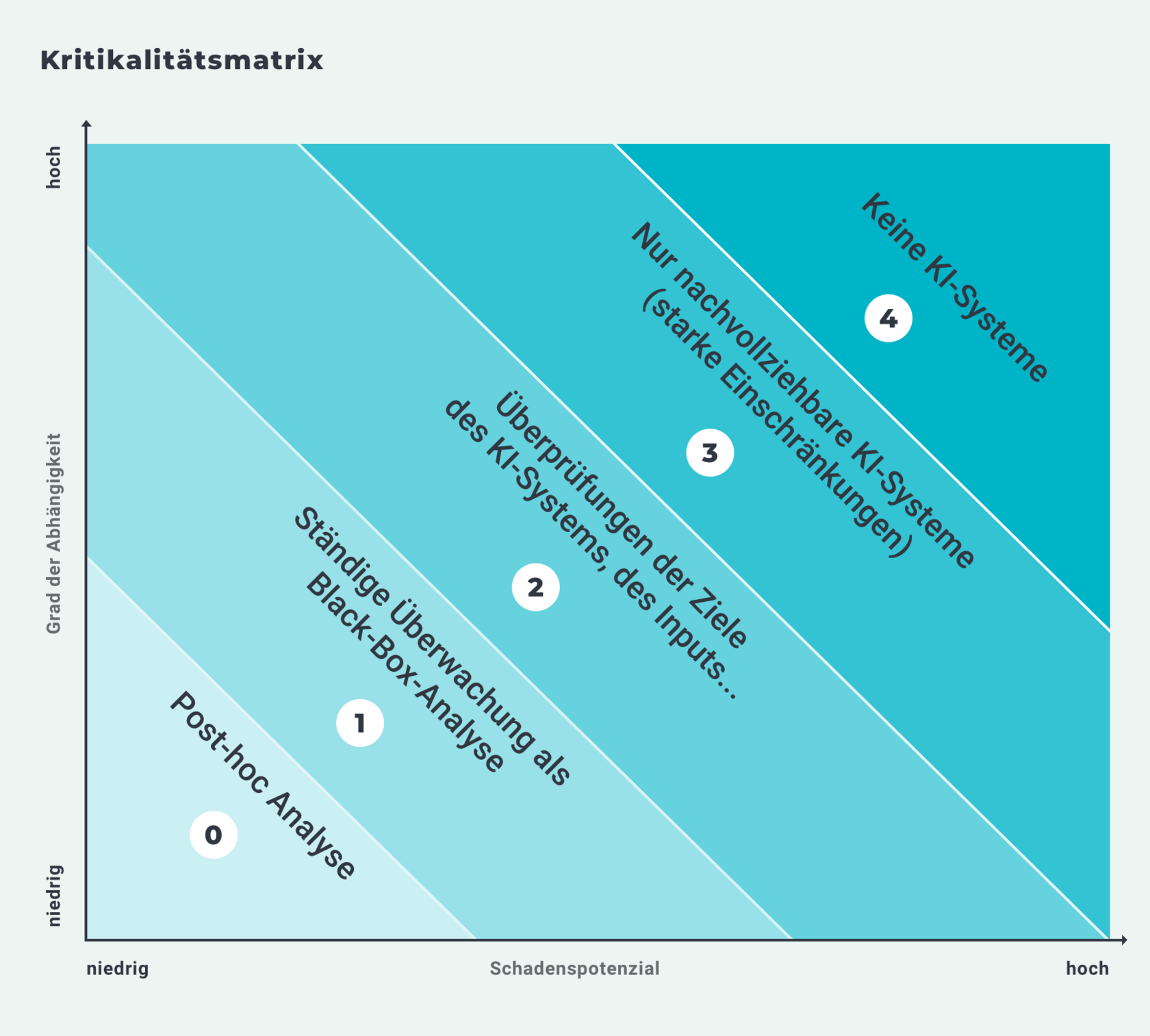

Die Abbildung 1 mit der Überschrift „Kritikalitätsmatrix“ enthält neben einem Achsendiagramm den folgenden beschreibenden Text: „Die Kritikalitätsmatrix von Tobias Krafft und Katharina Zweig unterscheidet fünf Kritikalitätsstufen der Anwendung von entscheidungsfällenden oder -unterstützenden KI-Systemen. Mit den aufeinander aufbauenden Klassen sind ansteigende Regulierungsanforderungen an die Transparenz und Nachvollziehbarkeit der Entscheidungslogik verknüpft“.

Datensatz

Auf der x-Achse des Achsendiagramms ist das Schadenspotenzial von entscheidungsfällenden oder -unterstützenden KI-Systemen von niedrig bis hoch abgetragen. Auf der y-Achse ist der Grad der Abhängigkeit dieser KI-Systeme von niedrig bis hoch abgetragen. Ausgehend vom Nullpunkt mit niedrigem Schadenspotenzial und niedrigem Grad der Abhängigkeit bis zum oberen rechten Ecke mit hohem Schadenspotenzial und hohem Grad der Abhängigkeit werden die fünf Kritikalitätsstufen mit gleichmäßigem Abstand dargestellt. Die erste Kritikalitätsstufe 0 trägt die Beschreibung „Post-hoc-Analyse“. Darauf folgen:

- Stufe 1 „Ständige Überwachung als Black-Box-Analyse“

- Stufe 2 „Überprüfungen der Ziele des KI-Systems, des Inputs, …“

- Stufe 3 „Nur nachvollziehbare KI-Systeme (starke Einschränkungen)“

- Stufe 4 „Keine KI-Systeme“.

Darstellung

Die Abbildung stellt mithilfe schräg angeordneter Balken von links unten nach rechts oben grafisch dar, wie die Regulierungsanforderungen an die Transparenz und Nachvollziehbarkeit der Entscheidungslogik von entscheidungsfällenden oder -unterstützenden KI-Systemen geknüpft sind. Die Grafik zeigt, dass die Regulierungsanforderungen mit dem Schadenspotenzial und dem Grad der Abhängigkeit ansteigen.

© Algorithm Accountability Lab [Prof. Dr K. A. Zweig], aalab.cs.uni-kl.de/resources/.

Ihr Modell sagt also: Je kritischer eine KI-Anwendung, desto höher die Anforderungen an Transparenz und Nachvollziehbarkeit. Wie lässt sich nachvollziehen, wie KI-Systeme zu einem Ergebnis gekommen sind, obwohl sie häufig als "Black Box" bezeichnet werden?

Neben der Transparenz technischer Details aus dem Entwicklungsprozess der KI bis hin zum eigentlichen System können verschiedene Teilschritte oder Komponenten so aufbereitet werden, dass man sie als Außenstehender verstehen und bewerten kann, um beispielsweise einer betroffenen Gruppe gegenüber Entscheidungen zu rechtfertigen oder aufzuklären, wieso es überhaupt zu der Entscheidung kam.

Unabhängig davon kann aber auch einem Domänenexperten Zugriff auf das System gewährt werden, damit dieser Testverfahren, die explizit für den Umgang mit Black Box Systemen geeignet sind, zur Überprüfung bestimmter Fragestellungen durchführen kann.

Hier liegt genau der Vorteil einer differenzierten, risikobasierten KI-Bewertung, denn aufgrund einer initialen Risikoabschätzung mithilfe der Kritikalitätsmatrix kann man im Einzelnen feststellen, welche Transparenz- und Nachvollziehbarkeitsmechanismen etabliert oder sogar gefordert werden könnten.

Was gibt es beim KI-Einsatz in der Arbeits- und Sozialverwaltung zu beachten? Macht es für die "Kritikalität" einen Unterschied, ob lernende Systeme in der Privatwirtschaft zum Einsatz kommen oder in der Arbeitslosen- oder Unfallversicherung?

Der Anwendungskontext eines KI-Systems hat selbstverständlich großen Einfluss auf mögliche Risiken.

Die oben genannten Beispiele verdeutlichen die Notwendigkeit der zweiten Dimension zur Bewertung eines Schadenspotenzials. In der Privatwirtschaft hat eine betroffene Person häufiger die Möglichkeit, einen Service nicht zu nutzen, oder aber einen alternativen Anbieter zu wählen, sollte sie Bedenken haben. Im Gegensatz dazu bietet der Einsatz im sozialen Sicherungssystem wenig Auswahl. Es gibt hier also einen gewissen Zwang, sich dem KI-System auszusetzen, wodurch die Kritikalität höher liegt. Das spricht natürlich nicht per se gegen den Einsatz in diesem Bereich, sondern zeigt nur, dass hier mit größerer Sorgfalt auf diese Risiken eingegangen werden muss.

Wo sehen Sie die größten Potenziale von KI in der Verwaltung? Welche KI-Anwendung würden Sie sich in der Arbeits- und Sozialverwaltung wünschen?

Bereits heute kann man in vielen Bereichen der Arbeits- und Sozialverwaltung gute KI-Anwendungen nutzen, die auf der Kritikalitätsmatrix als tendenziell unbedenklich eingestuft werden können. Dabei handelt es sich um relative generische Systeme zur Verbesserung der Arbeitsproduktivität, wie zum Beispiel die KI-gestützte Digitalisierung handgeschriebener Dokumente, aber auch um Diktat- oder Übersetzungssoftware. Meiner Erfahrung nach sind die Potenziale dieser Anwendungen noch lange nicht ausgeschöpft.

Darüber hinaus würde ich mir einen verstärkten Einsatz von KI-Anwendungen wünschen, die bürokratischen Aufwand reduzieren und vor allem Mitarbeiter bei unliebsamen Aufgaben unterstützen.

Tobias Krafft promoviert im Algorithm Accountability Lab, einer Forschungsgruppe der Technischen Universität Kaiserslautern. Ein Schwerpunkt seiner Arbeit liegt dabei auf der Erforschung gesellschaftlicher Auswirkungen von Algorithmen und Künstlicher Intelligenz (KI). Als Mitgeschäftsführer der Trusted AI GmbH berät er Unternehmen und öffentliche Träger in Fragen zu Entwicklung und Nutzung von KI-Systemen. Im September 2021 war er im Netzwerk KI in der Arbeits- und Sozialverwaltung zu Gast und erklärte, wie man zwischen kritischen und weniger kritischen KI-Anwendungen unterscheiden kann und welche Anforderungen die Systeme jeweils erfüllen sollten.